تواجه أنظمة الذكاء الاصطناعي (AI) اليوم تحديات في الحجم، مع متطلبات ذاكرة هائلة لضمان مشاركة البيانات بسرعة بين معالجات الرقائق. تم تصميم وحدات معالجة الرسومات التقليدية (GPU) أصلاً لأغراض غير مخصصة لنماذج الذكاء الاصطناعي، وعند دعم نماذج اللغة الكبيرة (LLM)، تحتاج إلى ربط عدة GPUs عبر شبكات عالية السرعة، مما يؤدي إلى نقل بيانات بطيء واستهلاك طاقة مرتفع.

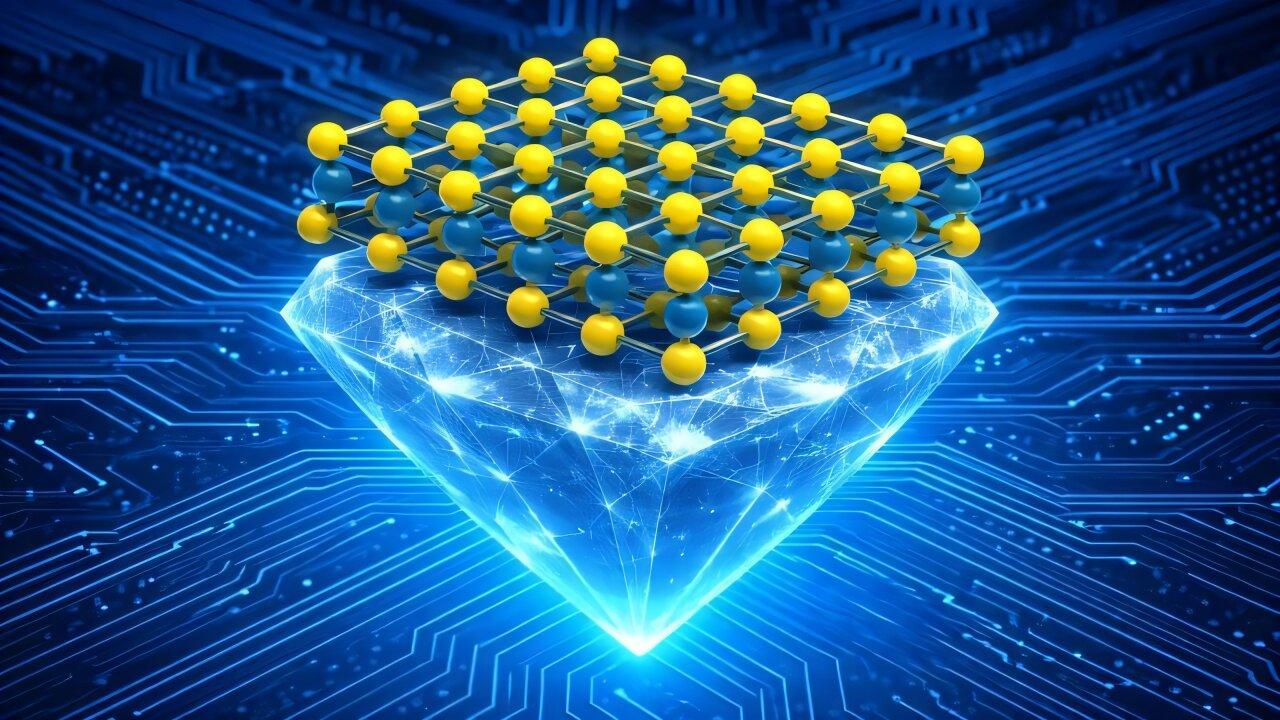

لكسر عنق الزجاجة في GPU، طورت شركات مثل Cerebras في كاليفورنيا معالجات على مستوى الرقاقة (wafer-scale processors)، وهي رقائق ذات مساحة كبيرة تحتوي على ذاكرة داخلية هائلة ومئات الآلاف من النوى. ومع ذلك، لا يكفي وجود رقائق على مستوى الرقاقة وحدها، بل تحتاج إلى أنظمة برمجية متخصصة. تعاونت جامعة إدنبرة وMicrosoft Research في تطوير WaferLLM، وهو نظام مصمم لتشغيل نماذج LLM الكبيرة بكفاءة على رقائق wafer-scale.

صمم WaferLLM ثلاث خوارزميات جديدة تقسم العمليات الرياضية الكبيرة إلى أجزاء أصغر، مما يتيح للنوى المجاورة معالجتها معاً، ونقل المعلومات محلياً، مما يتجنب الاتصالات طويلة المدى التي تبطئ السرعة. كما أدخل استراتيجيات جديدة لتوزيع أجزاء مختلفة من LLM على مئات الآلاف من النوى، مع تنسيق المعالجة والاتصال لضمان تشغيل الرقاقة بكفاءة. تم اختبار هذه التعديلات في مركز البيانات الدولي في إدنبرة، مما جعل رقائق wafer-scale تولد نصوصاً بسرعة أعلى بحوالي 100 مرة، وانخفاض التأخير بعشر مرات مقارنة بمجموعة من 16 GPU، مع تحسين كفاءة الطاقة مرتين.

رغم أن GPU تمتلك نظاماً بيئياً برمجياً ناضجاً، إلا أن رقائق wafer-scale أكثر ملاءمة لأحمال العمل التي تعتمد على تأخير منخفض للغاية، أو نماذج كبيرة جداً، أو كفاءة طاقة عالية. في الوقت نفسه، تتقدم تقنية GPU أيضاً. الدرس الأوسع هو أن بنية الذكاء الاصطناعي أصبحت مشكلة تصميم مشترك، حيث يجب أن تتطور الأجهزة والبرمجيات معاً، وإعادة التفكير في البرمجيات ضرورية لإطلاق أداء الجيل القادم من الذكاء الاصطناعي. بالنسبة للجمهور، ستدعم أنظمة الذكاء الاصطناعي تطبيقات كانت بطيئة أو مكلفة سابقاً، ويمثل تحول الحوسبة على مستوى الرقاقة دخول الذكاء الاصطناعي مرحلة جديدة.